Skynet es el nombre que recibe la inteligencia artificial que lidera al ejército de las máquinas en la saga de películas Terminator y el principal antagonista de esta. En la saga, Skynet es una Inteligencia artificial capaz de controlar el arsenal militar de los Estados Unidos con independencia de los humanos. [Referencia]

Normalmente no me pongo tan apocalíptico pero luego de ver el poder actual de procesamiento al que tenemos acceso y la evolución que ha tenido en los últimos años si da un poquito de emoción y miedo el no saber frente a que nos encontramos.

Hemos visto en los últimos 30 años mucho más avances tecnológicos que en los 30 años anteriores. Si nos ponemos a pensar que las computadoras personales y el internet apenas aparecieron en los hogares entre 1980 y 1990, vivimos una ola de desarrollos tecnológicos que no tiene precedentes. Y menciono a computadoras e internet porque es a lo que tengo acceso pero en el sector de la investigación:

«El Sunway TaihuLight encabeza el ranking de supercomputadoras con una potencia brutal que supera los 93 petaFLOPS y ha supuesto una revolución en China porque ha sido diseñado y fabricado con procesadores de cosecha propia en el centro de supercomputación nacional». [Referencia]

Hubo ya, una predicción que se cumple aún en estos días, en 1964 Arthur L. Samuel, del Centro de Investigación Watson de IBM escribió en una serie de artículos llamados «El mundo en 1984», un artículo titulado «The Banishment of Paper Work»:

«Aunque será completamente posible obtener una educación en casa, a través del propio computador personal, la naturaleza humana no habrá cambiado, y todavía habrá necesidad de escuelas con laboratorios, aulas y profesores que motiven a los alumnos». [Referencia]

La idea de un Skynet, fuera de que sea ciencia ficción es realmente alcanzable. Los equipos de computo y su poder de procesamiento están a unos cuantos años de lograr niveles jamás antes vistos de Inteligencia Artificial (IA).

Ya vemos como normal que la IA más básica nos puede llevar por la mejor ruta, nos puede recomendar películas y series, nos hace listas de reproducción o nos pone anuncios de cosas que no sabíamos que necesitamos.

Estamos en una transición de esos usos domesticos de IA a algo que en las manos equivocadas podrían llevarnos a ese futuro apocalíptico que vimos en las películas.

Cuando veo que hay quien está usando la IA para predecir quien ganará la Copa del Mundo en lugar de aprovechar ese procesamiento en algo realmente útil, me da miedo, mucho miedo. Mucho más cuando las predicciones son erróneas.

One of the first things I have come to realize while researching Artificial Intelligence (AI) is the difficulty to define it. That is why I would like to delve a bit deeper into the basics so both the reader and I can be on the same page.

According to the Wikipedia, AI is intelligence demonstrated by the machines, in contrast to the natural intelligence displayed by humans and many animals. A typical AI perceives its environment and takes actions that maximize its chance of successfully achieving its goals. These goals can be simple, or complex, can be explicitly stated or remain implicit in the problem, and they will usually depend on the task the AI is trying to solve.

At this point we need to make a distinction between AI and algorithms, and it may get a bit messy due to what is known as the “AI effect” which can be represented as follows: As soon as AI successfully solves a problem, the problem seems to no longer be a part of AI.

For example, when IBM’s chess playing computer Deep Blue succeeded in defeating Garry Kasparov in 1997, people complained that it had only used “brute force methods” and it wasn’t real intelligence. Fred Reed writes:

“A problem that proponents of AI regularly face is this: When we know how a machine does something ‘intelligent,’ it ceases to be regarded as intelligent. If I beat the world’s chess champion, I’d be regarded as highly bright.”

Fred Reed (2006–04–14) “Promise of AI not so bright”.

So let us back up; we have algorithms, which are a set of unambiguous instructions that a mechanical computer can execute, and that do not imply any use of “intelligence” because every set of possibilities have been considered, and every response to them has been hardcoded. This is how Deep Blue beat Garry Kasparov; every time the human player made a move the computer considered every possible move up until a certain depth, ranked them according to how likely they were to succeed and executed the move with the highest likelihood of giving the computer an advantage towards winning the game.

This is where a very interesting new concept comes in; “Machine learning”, which refers to the ability that AI has to “learn” new things. In the case of Deep Blue, unless changes were made to its code, the a priori chances of beating Kasparov the first time were the same as beating Kasparov after a thousand games, assuming that Kasparov’s level remained the same.

That is not the case anymore, the best chess AIs nowadays have the ability to learn every time they play, therefore, the initial algorithm tends to evolve to the point where the AI becomes a black box and its moves are unpredictable even for the people that have programmed it. With learning we refer to gaining the abilities to execute certain strategies that were not hardcoded when the AI was first released.

And here another closely related concept enters the picture, Big Data: data sets so big and complex that traditional data-processing application software are inadequate to deal with them. These data sets allow, for example, for an AI to examine and learn from every chess game ever recorded in a matter of hours.

So suddenly, if we mix AI with machine learning and big data, we end up with a domain specific intelligence that is many times more advanced than human intelligence. This combination has led to AIs performing many tasks, not just chess, much better than its human counterparts such as driving, face recognition, pattern recognition…

Everything seems to point towards a future where AI outperforms humans in every task, which starts to take us closer to the subject of this article; the implications that ethics will have for AI. Because even if machine learning allows machines to develop their own way of thinking, we can still hardcode a set of rules, or boundaries that the AI will never be able to break. The same way we can let a kid do anything he wants inside a sandbox except: 1) Exit the sandbox, 2) fight other kids, and 3) eat the sand; we can let AI do anything it wants, except for a set of rules that it is always obliged to abide.

In that respect, one of the most famous formulation was made by Isaac Asimov with the three laws of robotics, which we can easily make extensible to all AI:

- An AI may not injure a human being or, through inaction, allow a human being to come to harm.

- An AI must obey orders given it by human beings except where such orders would conflict with the First Law.

- An AI must protect its own existence as long as such protection does not conflict with the First or Second Law.

The original laws apply to just robots, but we are not sure what kind of container will AI have in the future. For example, movies such as 2001: A Space Odyssey or Her have showed more ethereal forms for sentient AIs.

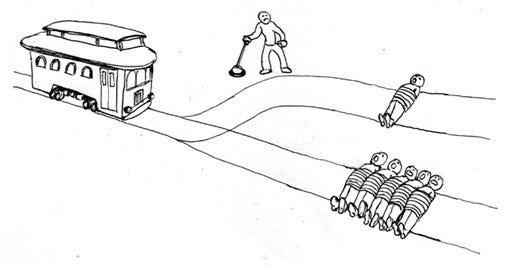

The problem with this laws is that there are some ethical problems were the AI in question has no choice but to break one of the laws, because it is forced to choose the least bad of two bad options. Probably the most illustrative of these problems is the Trolley Problem. The traditional thought experiment is presented as follows:

You see a runaway trolley moving toward five tied-up (or otherwise incapacitated) people lying on the tracks. You are standing next to a lever that controls a switch. If you pull the lever, the trolley will be redirected onto a side track and the five people on the main track will be saved. However, there is a single person lying on the side track. You have two choices:

1. Do nothing and allow the trolley to kill the five people on the main track.

2. Pull the lever, diverting the trolley onto the side track where it will kill one person.Which is the most ethical choice?

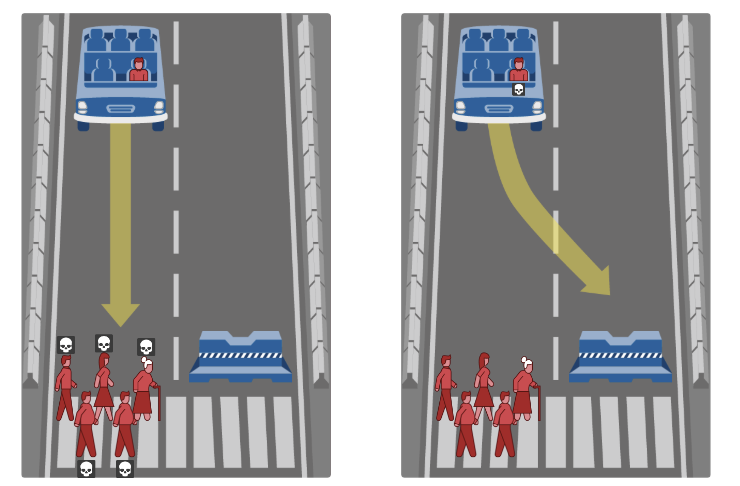

As you can see, this is a challenging situation which can be easily extensible to a self-driving car controlled by an AI. If the car is about to drive into a group of 5 and killed them all, should the AI steer the car and kill its passenger instead?

In this situation the computer must break Rule #1: An AI may not injure a human being or, through inaction, allow a human being to come to harm. His only options are either to injure the driver, or allow 5 people to come to harm through inaction.

Many possible solutions have been formulated for the Trolley Problem and its countless iterations, but, obviously, there is no definitive answer and I will leave it up to the reader to decide how she believes that the AI should be programmed. If you want to take the experiment a bit further, visit MIT’s great web page linked below the above image.

Another interesting angle is how AI seems to be more racist and sexist than human intelligence. When humans make decisions about hiring, or granting a bank loan, they’re more likely to be questioned about their judgement. But when it comes to AI, even if we were to try to guess what it based its decision on, we would be facing a black box; artificial neural networks just cannot explain their decisions.

We could try to mitigate this problem by telling the AI not to use racial data when granting loans, but there are many other correlated variables such as names (for example, in the United States, the last names Wei or DeShawn are highly correlated to Asian American and African American people respectively). Therefore, the AI could conclude the race and sex of the person using many proxy variables without ever taking into account those variables explicitly. And assuming that either race or sex are variables that determine the likelihood of, as an example, repayment of a loan, AIs would be more likely to deny loans or grant them in worse conditions based on racist or sexist biases.

A great article published on the award winning Canadian magazine, The Walrus, delves deeper into this problem:

“Let’s say we’re concerned about race as the factor of discrimination,” deep-learning pioneer Yoshua Bengio says. “Let’s say we see that, in our data, we can measure race.” Another constraint can be added to the neural network that compels it to ignore information about race, whether that information is implicit, like postal codes, or explicit. That approach can’t create total insensitivity to those protected features, Bengio adds, but it does a pretty good job.

The article adds:

A growing field of research, in fact, now looks to apply algorithmic solutions to the problems of algorithmic bias. This can involve running counterfactuals — having an algorithm analyze what might happen if a woman were approved for a loan, rather than simply combing through what’s happened in the past. It can mean adding constraints to an algorithm, ensuring that when it does make errors those errors are spread equally over every represented group. It’s possible to add a different constraint to the algorithm that lowers the threshold of, say, university acceptance for a particular group, guaranteeing that a representative percentage gets in — call it algorithmic affirmative action.

The problems mentioned above are just the tip of the iceberg, a small subset of issues we are currently facing. If we decide to think about the year 2100, after singularity and with sentient robots everywhere , the ethical problems become almost intractable from our current perspective:

- Should murdering a sentient robot be legally equated to murdering a human being?

- Is it morally correct to have robot slaves? What about sex slaves?

- Should we trust AIs if they are 99.99% sure that somebody was about to commit a crime, even if there are no conclusive evidence to support that accusation from a human intelligence perspective? This is the question that Philip K. Dick asks in the book The Minority Report.

- Should humans be allowed to marry AIs? Can AIs own assets? Should we let AIs decide who they belong to if its human owners get divorced?

All these questions make it obvious that philosophers, judges and ethics professors, among other experts, will become more relevant in the AI field. In the meantime, it is up to us to keep learning about AI to try to transition smoothly to the new world where AIs will be making most decision, and hope that we do not end up in a distopyan future such as the one in Alphaville, one of my favorite sci-fi movies.

¿Qué es la primero que piensas cuando escuchas inteligencia artificial?

Quizá lo primero que te viene a la mente son las películas de ciencia ficción como:

- Her(2014) - Spike Jonze

- I. Inteligencia Artificial (2001) - Steven Spielberg

- Ex_Machina(2014) - Alex Garland

- Tomorrowland: El mundo del mañana (2015) - Brad Bird

La definición de Inteligencia Artificial de acuerdo a merriam-webster es:

1: La rama de las ciencias de la computacion relacionada con la simulación del comportamiento inteligente en las computadoras

2: la capacidad de una máquina para imitar el comportamiento humano inteligente

Tipos de Inteligencia Artificial

De acuerdo a Arend Hintze los tipos de inteligencia artificial que existe son:

Máquinas reactivas

Sin duda, el estado más básico de la inteligencia artificial. Ni se almacenan recuerdos ni se utilizan para la toma de decisiones. El gran exponente fue Deep Blue, la máquina que batió a Kasparov, entonces campeón del mundo de ajedrez. Su misión es simplemente actuar a partir de lo que ven.

Máquinas con memoria limitada

La memoria limitada es un ejemplo de la inteligencia artificial de los coches autónomos, según el autor. Los coches sí tienen un mundo sobre el que recordar aspectos como autovías o semáforos, y a él añaden los detalles del momento presente, con datos sobre peatones o coches alrededor. De momento, tampoco se almacenan como recuerdos, aunque de cara al futuro podría ser útil en una misma ciudad antes de alcanzar un nivel de inteligencia superior.

Máquinas con una teoría en la mente

Este nivel comprende aquellas máquinas que son capaces de entender y expresar las emociones e ideas que del mundo a la vez que son capaces de tenerlas propias, adaptadas al mundo y respetando lo existente, pudiendo así trabajar en equipo y formar parte del día a día a día de los seres humanos.

Máquinas con conciencia propia

El nivel máximo, en el que las máquinas son capaces de verse a sí mismas con perspectiva en su entorno, de manera interna y siento capaces de predecir comportamientos y sentimientos ajenos. El sector está muy lejos de esto, la pregunta es cuándo llegará.

Inteligencia artificial es ahora

Microsoft muestra dos casos donde utilizar la Inteligencia Artificial para generar un beneficio exponencial.

The Yield

Una compañía de tecnología agrícola con sede en Australia, utiliza sensores, datos e inteligencia artificial (AI) para ayudar a los agricultores a tomar decisiones informadas relacionadas con el clima, el suelo y las condiciones de la planta.

Icotem

Empresa de París que crea modelos digitales en 3D de monumentos históricos amenazados por la guerra, el conflicto, el tiempo y la naturaleza.Con drones que pueden capturar miles de imágenes, Iconem ha examinado sitios en 20 países, incluyendo las ruinas de Pompeya de 109 acres, las antiguas ciudades asirias en el norte de Iraq y los restos montañosos de los monasterios budistas del tercer siglo en Afganistán. El equipo ha documentado Angkor Wat en Camboya y sitios en Hyderabad, India y Delos, Grecia. Las preservaciones digitales están ayudando a maestros, estudiantes e investigadores a comprender las civilizaciones a través de hitos históricos que a menudo son difíciles de acceder.

Herramientas tecnológicas

TensorFlow

TensorFlow™ es una biblioteca de software libre que se utiliza para realizar cálculos numéricos mediante diagramas de flujo de datos. Los nodos de los diagramas representan operaciones matemáticas y las aristas reflejan las matrices de datos multidimensionales (tensores) comunicadas entre ellas.

ONNX

ONNX es un formato abierto para representar modelos de aprendizaje profundo. Con ONNX, los desarrolladores de AI pueden mover modelos más fácilmente entre herramientas de última generación y elegir la combinación que sea mejor para ellos.

Chainer

Un marco flexible de redes neuronales

Microsoft Cognitive Toolkit

Es un juego de herramientas gratuito, fácil de usar, de fuente abierta y de grado comercial que entrena algoritmos de aprendizaje profundo para aprender como el cerebro humano.

Amazon Rekognition Image

Análisis exhaustivo de imágenes basado en aprendizaje profundo

Amazon Rekognition Video

Análisis de videos basado en aprendizaje profundo

Amazon Lex

Cree chatbots para interactuar con los clientes

Amazon Comprehend

Descubra información y relaciones en textos

Amazon Translate

Traducción fluida de textos

Amazon Transcribe

Reconocimiento de voz automático

Amazon Polly

Conversión de texto a habla natural

Esta lista solo es una muestra de las herramientas que estan al alcance de todos.

Conociendo el alcance y ventajas que ofrece la Inteligencia Artificial, me surge la siguiente pregunta:

¿Es un momento de analizar y decidir si podemos impliementarlas en nuestros proyectos para gener un diferenciador?

Referencias

- https://hipertextual.com/2016/12/tipos-de-inteligencia-artificial

- https://www.merriam-webster.com/dictionary/artificial%20intelligence

- https://azure.microsoft.com/en-us/overview/ai-platform/

- https://aws.amazon.com/es/machine-learning/

El término inteligencia artificial se vuelve cada vez más relevante. En la búsqueda de lo que realmente es IA, hay inmensos temas que me parecen importantes de analizar. En este post me enfocaré primero a lo que es IA, y después hablaré un poco (porque el tema es inmenso y podríamos ahondar muchísimo) a un tema que me parece extremadamente relevante, el uso positivo o negativo de la IA.

¿Qué es inteligencia artificial?

Generalizando un poco, el término IA actualmente nos lleva a pensar en máquinas y robots que pueden hacer cosas por nosotros, dejando de lado otras cosas que implican inteligencia artificial, desde tecnologías de traducción automática, aparatos inteligentes que usamos día a día, casas y ciudades inteligentes, entre otros.

Existen distintos tipos de inteligencia artificial:

- Artificial Narrow Intelligence (ANI). Aquella IA que se especializa solo en alguna tarea y no puede desarrollar otra tarea o análisis de data. Actualmente vivimos día a día con esta tecnología, por ejemplo, nuestros teléfonos inteligentes con mapas de navegación, Siri, también con nuestros autos, con parámetros específicos de inyección de combustible, o incluso redes como Facebook o Amazon, capaces de reunir y analizar información de tus preferencias para dar “recomendaciones que puedan interesarte”.

- Artificial General Intelligence (AGI). Aquella IA a la que nos referimos como Human-Level AI, como computadoras y/o máquinas que puedan desarrollar una actividad intelectual.

- Artificial Super Intelligence (ASI). Aquella IA que es más inteligente que el ser humano en varios campos, incluyendo creatividad científica, sabiduría general y habilidades sociales.

Es impresionante el desarrollo exponencial estos últimos años, y no nos hemos detenido a pensar realmente como la IA está cambiando y cambiará nuestro mundo en todos los sentidos, sobre todo en esta revolución digital que ha llevado a máquinas a conectar con el ser humano, conociendo gustos, preferencias y proveyendo información “adhoc”.

El uso de AI se vuelve extremadamente relevante en la propuesta de contenido distribuida digitalmente y la automatización del análisis de datos.

La cantidad de datos que producimos se duplica cada año. En 2016 produjimos tantos datos como en toda la historia de la humanidad hasta 2015. Cada minuto producimos cientos de miles de búsquedas de Google y publicaciones en Facebook. Estos contienen información que revela cómo pensamos y sentimos. Pronto, las cosas que nos rodean, posiblemente incluso nuestra ropa, también estarán conectadas con internet, (Helbing, 2017).

Hoy en día, los algoritmos saben muy bien lo que hacemos, lo que pensamos y cómo nos sentimos, posiblemente incluso mejor que nuestros amigos y familiares, o incluso a nosotros mismos, (Helbing, 2017).

En la búsqueda de aprender más de lo que es y su uso, dejamos de lado el reconocimiento de las aplicaciones negativas y positivas; y en caso de las aplicaciones negativas, cómo podemos pre venirlas y/o remediarlas.

¿A qué tipo de aplicaciones negativas o positivas me refiero?

Hay muchísimos, pero hablaré de cómo los algoritmos de búsqueda y los sistemas de recomendación pueden verse influenciados, y cómo pueden afectar el rumbo de la sociedad.

Las empresas pueden pujar por ciertas combinaciones de palabras para obtener resultados más favorables. Los gobiernos probablemente también puedan influir en los resultados. Durante las elecciones, pueden empujar a los votantes indecisos a apoyarlos, una manipulación que sería difícil de detectar. Por lo tanto, quienquiera que controle esta tecnología puede ganar las elecciones empujándose al poder, (Helbing, 2017).

Esta semana observé un video de “Conoce al rey de las fake news en México”. Dentro de la entrevista, hablan de cómo la mayoría de los trending topics de México son escritas por personas falsas en agencias de marketing, y su comienzo de “manipulación digital en 1999-2000”.

Ni siquiera sé qué tan real es todo el contenido del video, pero me preocupa. Es impresionante como los algoritmos pueden influenciar, como la creación de bots y ciber-delincuencia pueden manipular el destino de un país.

Como menciona Dirk Helbing en su artículo “Will Democracy Survive Big Data and Artificial Intelligence?”, para que la manipulación no se note, se necesita un llamado efecto de resonancia, sugerencias que son lo suficientemente personalizadas para cada individuo. De esta manera, las tendencias locales se refuerzan gradualmente mediante la repetición, conduciendo hasta la "burbuja de filtro" o el "efecto de cámara de eco": al final, todo lo recibido parece un reflejo de nuestras propias opiniones.

En el artículo de “preparing for malicious uses of AI”, Clark, Page y Amodei mencionan una investigación que está interesante (la dejo en las referencias). Esta investigación trata sobre cómo la IA desafía la seguridad global, crea nuevas amenazas y complica la atribución de ataques específicos, y muestran un reporte con recomendaciones de alto nivel para compañías, organizaciones de investigación, profesionales individuales y gobierno para garantizar un mundo más seguro. Es importante mencionar que esta investigación va más allá del tema antes mencionado, pero hacen enfoque a algunas prácticas que considero relevante para muchas organizaciones independientemente de la industria. Las menciono a continuación:

- Reconocer la naturaleza de doble uso de IA. IA es una tecnología capaz de aplicaciones inmensamente positivas e inmensamente negativas. Los gobiernos y los actores privados tendrán acceso a muchas de estas herramientas de inteligencia artificial y podrían usarlas para bien o daño público. Algunas posibles soluciones a estos problemas incluyen evaluaciones de riesgo previas a la publicación para ciertas partes de cada investigación, compartiendo selectivamente algunos tipos de investigación con un componente de seguridad significativo entre un pequeño conjunto de organizaciones de confianza.

- Aprender de seguridad cibernética. Existen diversas prácticas que son relevantes para los investigadores de IA y se podrían implementar en otras investigaciones. Van desde invertir en pronósticos tecnológicos para detectar amenazas, a convenciones de informes y más.

- Ampliar la discusión. AI va a alterar el panorama global de las amenazas, por lo que se debería involucrar a la sociedad en discusiones transversales. Podrían incluir sociedad civil, expertos en seguridad nacional, empresas, especialistas en ética, público en general y otros investigadores.

Como vemos, el tema de inteligencia artificial es muy amplio, pero es importante comenzar a darle la relevancia necesaria en cada ámbito, desde utilizarlo en empresas para optimizar procesos, hasta comprender el doble uso que podría dársele y canalizarlo de la mejor manera para la sociedad.

Bibliografía:

https://waitbutwhy.com/2015/01/artificial-intelligence-revolution-1.html

https://www.bsfrey.ch/articles/D_283_2017.pdf

https://blog.openai.com/preparing-for-malicious-uses-of-ai/

https://arxiv.org/pdf/1802.07228.pdf

[Referencia]

[Referencia]